IBM brachte den Personal Computer heraus. Personalcomputer vom Typ IBM PC

Normalerweise bestehen IBM PC-Personalcomputer aus den folgenden Teilen (Blöcken):

- Systemeinheit(in vertikaler oder horizontaler Ausführung);

- Monitor(Display) zum Anzeigen von Text- und Grafikinformationen;

- Tastaturen, mit dem Sie verschiedene Zeichen in den Computer eingeben können.

Die wichtigste Einheit in einem Computer ist die Systemeinheit; sie enthält alle Hauptkomponenten des Computers. Die PC-Systemeinheit enthält eine Reihe grundlegender technischer Geräte, von denen die wichtigsten sind: ein Mikroprozessor, ein Arbeitsspeicher, ein Nur-Lese-Speicher, Stromversorgung und Ein-/Ausgabeanschlüsse, Laufwerke.

Darüber hinaus können folgende Geräte an die PC-Systemeinheit angeschlossen werden:

- Drucker zum Drucken von Text- und Grafikinformationen;

- Manipulator vom Typ Maus- ein Gerät, das den Grafikcursor steuert

- Joystick, hauptsächlich in Computerspielen verwendet;

- Plotter oder Plotter- ein Gerät zum Drucken von Zeichnungen auf Papier;

- Scanner- ein Gerät zum Lesen von Grafik- und Textinformationen;

- CD-ROM- CD-Leser zum Abspielen von bewegten Bildern, Text und Ton;

- Modem- ein Gerät zum Informationsaustausch mit anderen Computern über das Telefonnetz;

- Streamer- ein Gerät zum Speichern von Daten auf Magnetband;

- Netzwerkadapter- ein Gerät, das es einem Computer ermöglicht, in einem lokalen Netzwerk zu arbeiten.

Die Hauptkomponenten eines Personalcomputers sind folgende Geräte: Prozessor, Speicher (RAM und extern), Geräte zum Anschluss von Terminals und Datenübertragung. Hier finden Sie eine Beschreibung der verschiedenen Geräte, die im Computer enthalten oder mit ihm verbunden sind.

Mikroprozessor

Ein Mikroprozessor ist ein großer integrierter Schaltkreis (LSI), der auf einem einzigen Chip aufgebaut ist und ein Element zur Erstellung von Computern unterschiedlicher Art und für verschiedene Zwecke darstellt. Er kann so programmiert werden, dass er eine beliebige logische Funktion ausführt, was bedeutet, dass der Mikroprozessor durch Programmänderungen gezwungen werden kann, Teil einer Recheneinheit zu sein oder die Ein-/Ausgabe zu steuern. An den Mikroprozessor können Speicher und Ein-/Ausgabegeräte angeschlossen werden.

IBM PC-Computer verwenden Intel-Mikroprozessoren sowie kompatible Mikroprozessoren anderer Unternehmen.

Mikroprozessoren unterscheiden sich voneinander in Typ (Modell) und Taktfrequenz (die Geschwindigkeit der Durchführung elementarer Operationen, angegeben in Megahertz - MHz). Die gängigsten Modelle von Intel sind: 8088, 80286, 80386SX, 80386DX, 80486, Pentium und Pentium-Pro, Pentium-II, Pentium-III, sie sind in der Reihenfolge steigender Leistung und Preis aufgeführt. Identische Modelle können unterschiedliche Taktraten haben – je höher die Taktrate, desto höher die Leistung und der Preis.

Die wichtigsten zuvor veröffentlichten Mikroprozessoren Intel 8088, 80286, 80386 enthalten keine speziellen Befehle zur Verarbeitung von Gleitkommazahlen. Um ihre Leistung zu steigern, können daher sogenannte mathematische Coprozessoren installiert werden, die die Leistung bei der Verarbeitung von Gleitkommazahlen erhöhen.

Erinnerung

Random Access Memory oder Random Access Memory (RAM) sowie Read-Only Memory (ROM) bilden den internen Speicher des Computers, auf den der Mikroprozessor im Betrieb direkten Zugriff hat. Alle Informationen während der Verarbeitung werden vom Computer zunächst vom externen Speicher (von Magnetplatten) in den RAM überschrieben. Das OP enthält Daten und Programme, die zum aktuellen Zeitpunkt des Computerbetriebs verarbeitet werden. Informationen im OP werden vom externen Speicher empfangen (kopiert) und nach der Verarbeitung wieder dorthin geschrieben. Informationen im OP bleiben nur während einer Arbeitssitzung erhalten und gehen beim Ausschalten des PCs oder bei einem Notstromausfall unwiederbringlich verloren. In diesem Zusammenhang muss der Benutzer regelmäßig Informationen, die einer Langzeitspeicherung unterliegen, während des Betriebs vom OP auf Magnetplatten schreiben, um deren Verlust zu vermeiden.

Je größer das RAM-Volumen, desto höher ist die Rechenleistung des Computers. Wie Sie wissen, wird zur Bestimmung der Informationsmenge eine Maßeinheit verwendet: 1 Byte, was eine Kombination aus acht Bits (Nullen und Einsen) ist. In diesen Maßeinheiten kann die im OP oder auf einer Diskette gespeicherte Informationsmenge als 360 KB, 720 KB oder 1,2 MB angegeben werden. Hier ist 1 KB = 1024 Byte und 1 MB (1 Megabyte entspricht 1.024 KB, während eine Festplatte 500 MB, 1000 MB oder mehr aufnehmen kann.

Für IBM PC XT-Volume OH. in der Regel sind es 640 KB, bei IBM PC AT mehr als 1 MB, bei älteren IBM PC-Modellen 1 bis 8 MB, es können aber auch 16, 32 MB und noch mehr sein – der Speicher kann durch Hinzufügen von Mikroschaltungen erweitert werden auf der Hauptplatine des Computers.

Im Gegensatz zu OP speichert ROM ständig dieselben Informationen und der Benutzer kann sie nicht ändern, obwohl er sie lesen kann. Typischerweise ist das ROM-Volumen klein und liegt zwischen 32 und 64 KB. Das ROM speichert verschiedene Programme, die werkseitig geschrieben werden und in erster Linie dazu dienen, den Computer beim Einschalten zu initialisieren.

1 MB RAM besteht in der Regel aus zwei Teilen: Die ersten 640 KB können vom Anwendungsprogramm und dem Betriebssystem (OS) genutzt werden. Der Rest des Speichers wird für Servicezwecke genutzt:

- zum Speichern eines Teils des Betriebssystems, der das Testen des Computers, das anfängliche Laden des Betriebssystems sowie die Durchführung grundlegender Ein-/Ausgabedienste auf niedriger Ebene ermöglicht;

- um Bilder auf den Bildschirm zu übertragen;

- zum Speichern verschiedener Betriebssystemerweiterungen, die zusammen mit zusätzlichen Computergeräten angezeigt werden.

Wenn man von der Größe des Arbeitsspeichers (RAM) spricht, meint man in der Regel den ersten Teil davon, der manchmal nicht ausreicht, um einige Programme auszuführen.

Dieses Problem wird durch die Verwendung von erweitertem und erweitertem Speicher gelöst.

Die Intel-Mikroprozessoren 80286, 80386SX und 80486SX können größere RAM-Größen (16 MB) und 80386 und 80486 (4 GB) verarbeiten, MS DOS kann jedoch nicht direkt mit RAM größer als 640 KB arbeiten. Um auf das zusätzliche OP zuzugreifen, wurden spezielle Programme (Treiber) entwickelt, die es ermöglichen, eine Anfrage vom Anwendungsprogramm zu empfangen und in den „geschützten Modus“ des Mikroprozessors zu wechseln. Nach Abschluss der Anfrage wechseln die Treiber in den normalen Betriebsmodus des Mikroprozessors.

Kasse

Cache ist ein spezieller Hochgeschwindigkeits-Prozessorspeicher. Es wird als Puffer verwendet, um die Arbeit des Prozessors mit dem OP zu beschleunigen. Neben dem Prozessor enthält der PC:

- elektronische Schaltkreise (Controller), die den Betrieb verschiedener im Computer enthaltener Geräte (Monitor, Laufwerke usw.) steuern;

- Ein- und Ausgabeports, über die der Prozessor Daten mit externen Geräten austauscht. Es gibt spezielle Ports, über die Daten mit den internen Geräten des Computers ausgetauscht werden, und Allzweck-Ports, an die verschiedene zusätzliche externe Geräte (Drucker, Maus usw.) angeschlossen werden können.

Es gibt zwei Arten von Universalanschlüssen: parallel mit der Bezeichnung LPT1–LPT9 und asynchron seriell mit der Bezeichnung COM1–COM4. Parallele Ports führen Ein- und Ausgaben schneller durch als serielle Ports, erfordern aber auch mehr Kabel für den Datenaustausch (der Port für die Domäne mit dem Drucker ist parallel und der Port für den Austausch mit dem Modem über das Telefonnetzwerk ist seriell).

Grafikkarten

Ein Monitor oder Display ist ein obligatorisches Peripheriegerät eines PCs und dient der Anzeige verarbeiteter Informationen aus dem Arbeitsspeicher des Computers.

Basierend auf der Anzahl der Farben, die bei der Darstellung von Informationen auf dem Bildschirm verwendet werden, werden Anzeigen in Monochrom und Farbe unterteilt, und basierend auf der Art der auf dem Bildschirm angezeigten Informationen – in symbolisch (nur symbolische Informationen werden angezeigt) und grafisch (sowohl symbolisch als auch grafisch). Informationen werden angezeigt). Ein Videocomputer besteht aus zwei Teilen: einem Monitor und einem Adapter. Wir sehen nur den Monitor, der Adapter ist im Gehäuse der Maschine versteckt. Der Monitor selbst enthält nur eine Kathodenstrahlröhre. Der Adapter enthält Logikschaltungen, die ein Videosignal ausgeben. Der Elektronenstrahl durchläuft den Bildschirm in etwa einer Fünfzigstelsekunde, das Bild ändert sich jedoch recht selten. Daher muss das auf den Bildschirm eingehende Videosignal erneut dasselbe Bild erzeugen (regenerieren). Zur Speicherung verfügt der Adapter über einen Videospeicher.

Im Zeichenmodus zeigt der Bildschirm in der Regel gleichzeitig 25 Zeilen mit 80 Zeichen pro Zeile an (insgesamt 2000 Zeichen - die Anzahl der Zeichen auf einem maschinengeschriebenen Standardblatt), und im Grafikmodus wird die Bildschirmauflösung bestimmt durch die Eigenschaften der Monitoradapterplatine – das Gerät zum Anschluss an die Systemeinheit .

Die Qualität des Bildes auf dem Monitorbildschirm hängt vom Typ des verwendeten Grafikadapters ab.

Die gängigsten Adaptertypen sind EGA, VGA und SVGA. Derzeit sind VGA und SVGA (SuperVGA) weit verbreitet. SVGA hat eine sehr hohe Auflösung. Früher wurde ein CGA-Adapter verwendet, der jedoch auf modernen Computern nicht mehr verwendet wird.

Adapter variieren" Auflösung" (für Grafikmodi). Die Auflösung wird anhand der Anzahl der Zeilen und der Anzahl der Elemente pro Zeile („Pixel“) gemessen, also Punkte pro Zeile. Beispielsweise zeigt ein Monitor mit einer Auflösung von 720 x 348 vertikal 348 Zeilen an Anzahl der Punkte: 720 Punkte pro Zeile. Verwenden Sie für Publishing-Systeme Monitore mit einer Auflösung von 800 x 600 und 1024 x 768. Solche Monitore sind sehr teuer.

Bildschirme gibt es in Standardgröße (14 Zoll), vergrößert (15 Zoll) und groß wie ein Fernseher (17, 20 und sogar 21 Zoll – also 54 cm Diagonale), Farbe (von 16 bis zu mehreren zehn Millionen Farben) und Monochrom.

Der Monitoradapterstandard bestimmt auch die Anzahl der Farben in der Palette der Farbmonitore: CGA im Grafikmodus hat 4 Farben, EGA hat 64 Farben, VGA hat bis zu 256 Farben und SVGA hat mehr als eine Million Farben. Im Textmodus ermöglichen Ihnen alle aufgeführten Standards die Wiedergabe von 16 Farben.

Die Wahl des einen oder anderen Monitortyps hängt von der Art des Problems ab, das auf einem PC gelöst werden soll. Wenn der Benutzer beispielsweise nur Textinformationen verarbeitet, reicht ihm ein monochromer Zeichenmonitor aus. Wenn er jedoch Probleme löst (computergestütztes Design), benötigt er einen Farbgrafikmonitor. Für die meisten Anwendungen ist jedoch eine Farbgrafik erforderlich Monitore und Adapter sind vorzuziehen.

Laufwerke

Informationsspeichergeräte – ein integraler Bestandteil jedes Computers – werden oft als externe Speichermedien oder externer Computerspeicher bezeichnet. Sie sind für die langfristige Speicherung umfangreicher Informationen konzipiert, wobei ihr Inhalt nicht vom aktuellen Zustand des PCs abhängt. Alle Daten und Programme werden auf externen Medien gespeichert, sodass hier eine Bibliothek mit Benutzerdaten erstellt und gespeichert wird.

Informationsspeichergeräte in Personalcomputern sind Magnetplattenlaufwerke(NMD), in dem der direkte Zugang zu Informationen organisiert wird. Kürzlich sind dort auch für PCs erschienen Magnetbandlaufwerke- Streamer, die sehr große Informationsmengen enthalten können, gleichzeitig aber nur den sequentiellen Zugriff darauf organisieren. Streamer ersetzen jedoch keine Magnetplattenlaufwerke, sondern ergänzen diese lediglich. Es gibt genügend NMDs: Diskettenlaufwerke (FMD) und Festplattenlaufwerke (HDD).

Festplatten sind für die dauerhafte Speicherung von Informationen konzipiert. Auf einem IBM-PC mit 80286-Mikroprozessor beträgt die Festplattenkapazität normalerweise 20 bis 40 MB, bei 80386 SX, DX und 80486SX – bis zu 300 MB, bei 804S6DX bis zu 500-600 MB, bei PENTIUM – mehr als 2 GB .

Die Festplatte ist eine nicht entfernbare Magnetplatte, die durch ein hermetisch verschlossenes Gehäuse geschützt ist und sich innerhalb der Systemeinheit befindet. Es kann aus mehreren Scheiben mit zwei magnetischen Oberflächen bestehen, die zu einem Paket zusammengefasst sind.

Im Gegensatz zu einer Diskette können Sie auf einer Festplatte große Informationsmengen speichern, was dem Benutzer mehr Möglichkeiten bietet.

Beim Arbeiten mit einer Festplatte muss der Benutzer wissen, wie viel Speicher durch auf Datenträgern gespeicherte Daten und Programme belegt wird, wie viel freier Speicher verfügbar ist, die Speicherfüllung steuern und Informationen sinnvoll darin platzieren. Die gängigsten Diskettengrößen sind 5,25 und 3,5 Zoll.

Mit Diskettenlaufwerken (FHD) können Sie Informationen von einem Computer auf einen anderen übertragen, Informationen speichern, die nicht ständig auf dem Computer verwendet werden, und Archivkopien der auf der Festplatte gespeicherten Informationen erstellen. Eine Diskette (Diskette) ist eine dünne Scheibe aus einem speziellen Material, auf deren Oberfläche eine magnetische Beschichtung aufgebracht ist. Auf dem Kunststoffgehäuse der Diskette befinden sich ein rechteckiger Schlitz zum Aufnahmeschutz, ein Loch für den Kontakt der Magnetplatte mit den Leseköpfen des Diskettenlaufwerks und ein Etikett mit den Parametern der Diskette.

Der Hauptparameter einer Diskette ist ihr Durchmesser. Derzeit gibt es zwei Hauptstandards für Diskettenlaufwerke – Disketten mit einem Durchmesser von 3,5 und 5,25 Zoll (89 bzw. 133 mm). In der Regel kommen bei IBM PC XT und IBM PC AT hauptsächlich Disketten mit einem Durchmesser von 5,25 Zoll zum Einsatz, bei älteren IBM PC-Modellen kommen Disketten mit einem Durchmesser von 3,5 Zoll zum Einsatz.

Zum Schreiben und Lesen von Informationen wird die Diskette in den Laufwerksschacht eingebaut, der sich in der Systemeinheit befindet. Ein PC kann über ein oder zwei Festplattenlaufwerke verfügen. Da es sich bei einer Diskette um ein Wechselmedium handelt, dient sie nicht nur zum Speichern von Informationen, sondern auch zum Übertragen von Informationen von einem PC auf einen anderen.

5,25-Zoll-Disketten können je nach Produktionsqualität Informationen von 360, 720 KB oder 1,2 MB enthalten.

Die maximale Kapazität von 3,5-Zoll-Disketten können Sie anhand ihres Aussehens ermitteln: Disketten mit einer Kapazität von 1,44 MB haben einen speziellen Steckplatz in der unteren rechten Ecke, Disketten mit einer Kapazität von 720 KB jedoch nicht. Diese Disketten sind in einem Hartplastikgehäuse untergebracht, was ihre Zuverlässigkeit und Haltbarkeit deutlich erhöht. In diesem Zusammenhang ersetzen 3,5-Zoll-Disketten bei neuen Computern die 5,25-Zoll-Disketten.

Schreibschutz von Disketten. 5,25-Zoll-Disketten verfügen über einen Schreibschutzschlitz. Wenn dieser Steckplatz verschlossen ist, ist ein Beschreiben der Diskette nicht möglich. Auf 3,5-Zoll-Disketten gibt es Schreibschutzschlitze und einen speziellen Schalter – einen Riegel, der das Schreiben auf die Diskette zulässt oder verhindert. Aufnahmeberechtigungsmodus – das Loch ist geschlossen, wenn das Loch offen ist, ist die Aufnahme verboten.

Initialisieren (Formatieren) von Disketten. Vor der ersten Verwendung muss die Diskette auf besondere Weise initialisiert (markiert) werden.

Moderne Computer verfügen neben herkömmlichen Laufwerken über spezielle Laufwerke für Laser-Compact-Discs (CD-ROM) sowie für magnetisch-optische Platten und Bernoulli-Scheiben.

CD-ROM - CDs, viele große Softwarepakete für moderne Computer werden auf solchen Datenträgern erstellt. CD-ROM-Laufwerke unterscheiden sich in der Geschwindigkeit der Informationsübertragung - normal, doppelt, vierfach usw. Geschwindigkeit. Moderne Festplattenlaufwerke mit 24 bis 36 Geschwindigkeiten arbeiten nahezu mit der Geschwindigkeit einer Festplatte.

Eine typische CD hat eine Kapazität von mehr als 600 MB oder 600 Millionen Zeichen, ist jedoch nur zur Wiedergabe gedacht und ermöglicht keine Aufnahme. Wiederbeschreibbare CDs und entsprechende Laufwerke sind bereits erhältlich, allerdings sehr teuer. Derzeit werden Sets mit Fotos in hervorragender Qualität, Discs mit Videoclips und Filmen auf CDs verkauft. Spielesets mit verschiedenen Musik- und Soundeffekten, Computer-Enzyklopädien, Lernprogramme – all das erscheint nur auf CD.

Drucker und Plotter

Ein Drucker (Druckgerät) dient dazu, Text- und Grafikinformationen aus dem Arbeitsspeicher des Computers auf Papier auszugeben. Das Papier kann entweder ein Blatt oder eine Rolle sein.

Der Hauptvorteil von Druckern ist die Möglichkeit, eine große Anzahl von Schriftarten zu verwenden, wodurch Sie recht komplexe Dokumente erstellen können. Schriftarten unterscheiden sich in der Breite und Höhe der Buchstaben, ihrer Neigung und den Abständen zwischen Buchstaben und Linien.

Um mit dem Drucker arbeiten zu können, muss der Benutzer die benötigte Schriftart auswählen und die Druckparameter so einstellen, dass sie der Breite des Ausgabedokuments und der Größe des verwendeten Papiers entsprechen. Auf dieser Grundlage gibt es beispielsweise bei Nadeldruckern zwei Modifikationen: Drucker mit schmalem Schlitten (Breite eines Standard-Schreibmaschinenblatts) und Drucker mit breitem Schlitten (Breite eines Standard-Schreibmaschinenblatts).

Es muss beachtet werden, dass die Größe des „Computerblatts“ (der vom PC dem Benutzer zum Ausfüllen mit symbolischen Informationen zugewiesene Platz) die Größe des Monitorbildschirms deutlich übersteigt und Hunderte von Spalten und Tausende von Zeilen umfasst wird durch die Menge an freiem RAM auf dem Computer und der verwendeten Software bestimmt. Bei der Ausgabe von Informationen an einen Drucker wird der Inhalt des gesamten Computerblatts gedruckt und nicht nur der auf dem Bildschirm sichtbare Teil. Daher ist es zunächst notwendig, den für den Druck vorbereiteten Text in Seiten aufzuteilen und dabei die erforderliche Textbreite basierend auf der Schriftart und der Papierbreite einzustellen.

Drucker können grafische Informationen und sogar in Farbe ausgeben. Es gibt Hunderte von Druckermodellen. Sie können von den folgenden Typen sein: Matrix, Tintenstrahl, beschriftet, Laser.

Bis vor Kurzem waren die am häufigsten verwendeten Drucker Nadeldrucker, deren Druckkopf eine vertikale Reihe dünner Metallstäbe (Nadeln) enthielt. Der Kopf bewegt sich entlang der gedruckten Linie und die Stäbe treffen im richtigen Moment durch das Farbband auf das Papier. Dies gewährleistet die Entstehung eines Bildes auf Papier. Günstige Drucker verwenden 9-Nadel-Köpfe und die Druckqualität ist eher mittelmäßig, was mit ein paar Durchgängen verbessert werden kann. Drucker mit 24 oder 48 Kernen bieten eine höhere Qualität und eine ausreichende Druckgeschwindigkeit. Druckgeschwindigkeit – von 10 bis 60 Sekunden pro Seite. Bei der Auswahl eines Druckers sind die Menschen in der Regel an der Möglichkeit interessiert, russische und kasachische Buchstaben zu drucken. In diesem Fall ist es möglich:

- In den Drucker können Schriftarten mit kasachischen und russischen Buchstaben integriert werden. In diesem Fall ist der Drucker nach dem Einschalten sofort bereit, Texte in Kasachisch und Russisch zu drucken. Wenn die Codes der kasachischen und russischen Buchstaben mit denen im Computer übereinstimmen, können die Texte mit den DOS-Befehlen PRINT oder COPY ausgedruckt werden. Wenn die Codes nicht übereinstimmen, müssen Sie Transkodierungstreiber verwenden.

- Im Drucker-ROM fehlen Schriftarten mit kasachischen und russischen Buchstaben. Dann müssen Sie vor dem Drucken von Texten den Treiber zum Laden der Buchstabenschrift herunterladen. Wenn der Drucker ausgeschaltet wird, verschwinden sie aus dem Speicher.

Nadeldrucker einfach zu bedienen, haben die niedrigsten Kosten, aber eher geringe Produktivität und Druckqualität, insbesondere bei der Ausgabe von Grafikdaten.

Tintenstrahldrucker Das Bild wird durch Mikrotropfen spezieller Tinte erzeugt. Sie sind teurer als Nadeldrucker und erfordern eine sorgfältige Wartung. Sie arbeiten geräuschlos, verfügen über viele integrierte Schriftarten, reagieren jedoch sehr empfindlich auf die Papierqualität – die Qualität und Produktivität von Tintenstrahldruckern ist höher als die von Nadeldruckern. Zu den Nachteilen zählen: relativ hoher Tintenverbrauch und Feuchtigkeitsinstabilität der gedruckten Dokumente.

Laserdrucker sorgen für die beste Druckqualität und nutzen das Prinzip der Xerographie – das Bild wird von einer speziellen Trommel, an der Tintenpartikel elektrisch angezogen werden, auf Papier übertragen. Der Unterschied zu einem xerografischen Gerät besteht darin, dass die Drucktrommel mithilfe eines Laserstrahls entsprechend den Befehlen des Geräts elektrifiziert wird. Die Auflösung dieser Drucker liegt zwischen 300 und 1200 dpi. Die Druckgeschwindigkeit beträgt bei der Textausgabe 3 bis 15 Sekunden pro Seite. Laserdrucker bieten die beste Druckqualität und Leistung, sind jedoch die teuersten der getesteten Druckertypen.

Plotter(Plotter) dient ebenfalls der Darstellung von Informationen auf Papier und wird hauptsächlich zur Darstellung grafischer Informationen eingesetzt. Plotter werden häufig in der Designautomatisierung eingesetzt, wenn es darum geht, Zeichnungen von zu entwickelnden Produkten zu erhalten. Plotter werden in einfarbige und farbige Plotter sowie nach der Qualität der Informationsausgabe beim Drucken unterteilt.

Computer-Eingabegeräte

Tastatur - Das Hauptgerät zur Eingabe von Informationen in den Computer ist nach wie vor die Tastatur; Sie können damit Textinformationen eingeben und dem Computer Befehle erteilen. In der nächsten Lektion erfahren Sie mehr über die Tastaturfunktionalität.

Maus Zusammen mit der Tastatur dient es der Steuerung des Computers. Hierbei handelt es sich um ein separates kleines Gerät mit zwei oder drei Tasten, das der Benutzer entlang der horizontalen Oberfläche des Desktops bewegt und bei Bedarf die entsprechenden Tasten drückt, um bestimmte Vorgänge auszuführen.

Scanner ermöglicht die Eingabe jeglicher Art von Informationen von einem Blatt Papier aus in einen Computer. Der Eingabevorgang ist einfach, bequem und recht schnell.

Zusätzliche Geräte

Modems(Modulator-Demodulator) werden zur Datenübertragung zwischen Computern verwendet und unterscheiden sich hauptsächlich in der Geschwindigkeit der Informationsübertragung. Die Geschwindigkeiten von Modems variieren heute zwischen 2.400 Bit/Sek. und 25.000.000 Bit/Sek. Sie unterstützen bestimmte Standards für Datenaustauschverfahren (Protokolle). Wenn Sie eine Verbindung zu einem Computernetzwerk (Internet, Relcom, FidoNet usw.) herstellen oder E-Mail verwenden möchten, ist ein Modem das wichtigste Gerät.

Es gibt auch Faxmodems, die die Funktionen eines Modems mit denen eines Faxgeräts vereinen. Mit einem Faxmodem können Sie Textinformationen nicht nur an den Computer Ihres Abonnenten, sondern auch an ein einfaches Faxgerät senden und entsprechend empfangen. Faxmodems sind etwas teurer als Modems, bieten aber umfangreichere Möglichkeiten.

Heutzutage spricht man oft von den Multimediafähigkeiten von Computern. Multimedia ist eine moderne Methode zur Darstellung von Informationen, die auf der Nutzung der Text-, Grafik- und Tonfähigkeiten eines Computers basiert, d.h. Dabei handelt es sich um die kombinierte Verwendung von Bild, Ton, Text, Musik und Animation, um Daten besser auf dem Bildschirm darzustellen. Ein Computer mit solchen Fähigkeiten muss über eine Soundkarte und ein CD-ROM-Laufwerk verfügen, die Farben, Soundtracks und Videos von einer normalen CD wiedergeben können. Multimedia-Computer können auch eine spezielle Grafikkarte zum Anschluss einer Videokamera, eines Videorecorders und eines Fernsehsignalempfangsgeräts enthalten.

Kontrollfragen

1. Listen Sie die wichtigsten PC-Komponenten und Zusatzgeräte auf.

2. Welche Drucker werden beim Betrieb eines PCs verwendet?

3. Welche Videoadapter kennen Sie? Was ist der Unterschied zwischen einem Display und einem Videoadapter?

4. Welche Disketten werden auf Ihrem Computer verwendet?

5. Was ist ein Modem und wofür wird es verwendet?

Der weltweit erste Mikroprozessor erschien 1971. Es handelte sich um einen Vier-Bit-Mikroprozessor Intel 4004. 1973 kam dann der Acht-Bit-Intel 8080 auf den Markt. Die allerersten Mikrocomputer wurden auf Basis dieses Prozessors entwickelt. Diese Maschinen hatten nur sehr geringe Fähigkeiten und wurden einfach als lustiges, aber wenig nützliches Spielzeug angesehen. 1979 kamen die ersten 16-Bit-Mikroprozessoren Intel 8086 und Intel 8088 auf den Markt. Basierend auf dem Intel 8086 brachte IBM 1981 einen Personal Computer auf den Markt IBM-PC(PC – Personal Computer – Personal Computer), in seinen Fähigkeiten bereits den damals existierenden Mini-Computern nahe. Aufgrund ihrer geringen Kosten und Benutzerfreundlichkeit erfreuten sich diese Computer sehr schnell weltweit großer Beliebtheit. Wenig später erschien der Personal Computer IBM PC/XT(XT – Extended Technology – erweiterte Technologie) mit maximal möglicher RAM-Größe bis zu 1 MB. Der nächste große Schritt in der Entwicklung der Mikroprozessortechnologie war die Einführung von Personalcomputern im Jahr 1983 IBM PC/AT(AT – Advanced Technology – fortschrittliche Technologie) basierend auf dem Intel 80286-Mikroprozessor mit der maximal möglichen RAM-Größe, erweitert auf 16 MB. Und Ende der 80er Jahre wurden 32-Bit-Intel 80386 mit der maximal möglichen Speicherkapazität von 4 GB auf den Markt gebracht. Anfang der neunziger Jahre erschien ein leistungsstärkerer 32-Bit-Mikroprozessor Intel 80486, der mehr als eine Million Transistorelemente auf einem Chip vereinte. Die Intel-Familie entwickelt sich weiter und im Jahr 1994 wurden Personalcomputer auf Basis eines Mikroprozessors entwickelt Pentium, das während der Entwicklung als Intel 80586 bezeichnet wurde. Derzeit sind bereits mehrere Modelle mit der Marke Pentium im Einsatz – Pentium II, Pentium MMX (mit erweiterten Multimedia-Funktionen), Pentium III und Pentium IV. Jedes nachfolgende Modell unterscheidet sich vom vorherigen durch die Erweiterung des Befehlssystems, die Erhöhung der Taktrate, die möglichen Mengen an RAM und Festplatten sowie die Steigerung der Gesamteffizienz. Es werden ständig neue, fortschrittlichere Modelle entwickelt.

Computer der IBM PC-Familie erwiesen sich als so erfolgreich, dass sie in fast allen Ländern der Welt dupliziert wurden. Gleichzeitig stellte sich heraus, dass die Computer hinsichtlich der Datenkodierungsmethoden und Befehlssysteme gleich waren, sich jedoch in technischen Eigenschaften, Aussehen und Kosten unterschieden. Solche Maschinen werden IBM-kompatible Personalcomputer genannt. Programme, die für die Ausführung auf einem IBM-PC geschrieben wurden, können genauso gut auf IBM-kompatiblen Computern ausgeführt werden. In solchen Fällen wird davon ausgegangen, dass dies der Fall ist Softwarekompatibilität.

Andere Architekturen

Die Maschinen der IBM PC-Familie gehören zu den sogenannten CISC-Computerarchitektur (CISC – Complete Instruction Set Computer – ein Computer mit einem vollständigen Befehlssatz). In den auf dieser Architektur aufgebauten Befehlssystemen von Prozessoren ist für jede mögliche Aktion eine eigene Anweisung vorgesehen. Beispielsweise besteht der Befehlssatz des Intel Pentium-Prozessors aus mehr als 1000 verschiedenen Anweisungen. Je umfangreicher der Befehlssatz ist, desto mehr Speicherbits werden benötigt, um jeden einzelnen Befehl zu kodieren. Besteht das Befehlssystem beispielsweise nur aus vier Aktionen, dann werden zu deren Kodierung nur zwei Bit Speicher benötigt, acht mögliche Aktionen erfordern drei Bit Speicher, sechzehn erfordern vier usw. Die Erweiterung des Befehlssystems bringt also eine Vergrößerung mit sich die Anzahl der für einen Maschinenbefehl zugewiesenen Bytes und damit die Menge an Speicher, die zum Aufzeichnen des gesamten Programms als Ganzes erforderlich ist. Darüber hinaus erhöht sich die durchschnittliche Ausführungszeit einer Maschinenanweisung und damit auch die durchschnittliche Ausführungszeit des gesamten Programms.

Mitte der 80er Jahre erschienen die ersten Prozessoren mit reduziertem Befehlssatz, gebaut nach dem sogenannten RISC-Architektur (RISC – Reduce Instruction Set Computer – ein Computer mit einem verkürzten Befehlssystem). Die Befehlssysteme von Prozessoren mit dieser Architektur sind viel kompakter, sodass Programme, die aus in diesem System enthaltenen Befehlen bestehen, deutlich weniger Speicher benötigen und schneller ausgeführt werden. Für viele komplexe Aktionen sind in solchen Systemen jedoch keine separaten Befehle vorgesehen. Wenn solche Maßnahmen notwendig werden, werden sie emuliert Vorhandenes nutzen Befehle Allgemein gesagt, Emulation ist die Ausführung von Aktionen eines Geräts mit den Mitteln eines anderen Geräts ohne Funktionsverlust. In diesem Fall geht es um die Durchführung der notwendigen komplexen Aktionen, für die die Befehle im System abgeschnitten sind nicht vorgesehen Verwenden einer bestimmten im System verfügbaren Befehlsfolge. Natürlich gibt es einen gewissen Verlust an Prozessoreffizienz.

Die bekannten Maschinen des Unternehmens gehören zur RISC-Architektur Apple Macintosh, die über ein Befehlssystem verfügen, das ihnen teilweise eine höhere Leistung im Vergleich zu Maschinen der IBM PC-Familie bietet. Ein weiterer wichtiger Unterschied zwischen diesen Maschinen besteht darin, dass viele der Funktionen, die in der IBM PC-Familie durch den Kauf, die Installation und die Konfiguration zusätzlicher Hardware bereitgestellt werden, in die Macintosh-Maschinenfamilie integriert sind und keine Hardwarekonfiguration erfordern. Zwar sind Macintosh-Maschinen teurer als Maschinen der IBM-Familie mit ähnlichen Parametern.

Maschinen aus den Familien von Sun Microsystems, Hewlett Packard und Compaq, die ebenfalls zur RISC-Architektur gehören. Als Vertreter anderer Architekturen können wir auch Familien tragbarer Computer dieser Klassen erwähnen Notizbuch(tragbar) und Handheld(manuell), die klein, leicht und autark sind. Diese Eigenschaften ermöglichen den Einsatz der genannten Geräte auf Geschäftsreisen, bei Geschäftstreffen, wissenschaftlichen Konferenzen etc., kurz gesagt, dort, wo der Zugang zu fest installierten Computern eingeschränkt oder unmöglich ist, beispielsweise im Zug oder Flugzeug.

Kontrollfragen

1. Definieren Sie das Konzept der „Computerarchitektur“.

2. Nennen Sie die drei Hauptgruppen von Computergeräten.

3. Was ist ein Zahlensystem und welche Zahlensysteme werden in Personalcomputern zur Verschlüsselung von Informationen verwendet?

4. Was sind die Unterschiede und Gemeinsamkeiten zwischen einem Bit und einem Byte?

5. Wie werden Textinformationen in einem PC kodiert?

6. Wie werden grafische Informationen in einem PC kodiert?

7. Definieren Sie die Konzepte „Pixel“, „Raster“, „Auflösung“, „Scannen“.

8. Was ist die Speicherkapazität und in welchen Einheiten wird sie gemessen?

9. Wie ähneln und unterscheiden sich RAM und externer Speicher voneinander?

10. Definieren Sie die Konzepte „Laden“ und „Starten“ eines Programms.

11. Beschreiben Sie Diskettenlaufwerke.

13. Beschreiben Sie die Grundregeln für den Umgang mit Disketten.

14. Definieren Sie die Konzepte „Arbeitsfläche“, „Spur“, „Sektor“, „Cluster“.

15. Wie ermittelt man das Volumen von Festplattenspeichermedien?

16. Warum müssen Magnetplatten formatiert werden?

17. Beschreiben Sie Festplatten.

18. Beschreiben Sie optische und magnetooptische Laufwerke.

19. Vergleichen Sie Disketten, Festplatten, optische und magnetooptische Platten.

20. Wie viele Festplattengeräte kann es in Personalcomputern geben? Wie werden sie bezeichnet?

21. Beschreiben Sie die Hauptfunktionen eines Prozessors.

22. Definieren Sie die Konzepte „Befehlssystem“, „Maschinenbefehl“, „Maschinenprogramm“.

23. Geben Sie die wichtigsten technischen Merkmale der Prozessoren an.

24. Was ist ein Übersetzer und warum wird er benötigt?

25. Wozu braucht man einen Reifen? Was wird durch seine Kapazität bestimmt?

26. Was ist ein Motherboard?

27. Welche Computergeräte befinden sich in der Systemeinheit?

28. Geben Sie eine Klassifizierung der Displays an und geben Sie deren Grundmodelle an.

29. Wofür werden Adapter verwendet?

30. Nennen Sie die Hauptbetriebsarten der Tastatur.

30. Wozu dienen die Funktionstasten?

31. Was ist eine Tastenkombination?

32. Was ist ein Textcursor?

33. Erklären Sie, wie Text scrollt.

34. Was ist ein Textbildschirm?

35. Beschreiben Sie die grundlegenden Möglichkeiten zum Bewegen eines Textcursors.

36. Wozu dient eine Maus?

37. Geben Sie die wichtigsten Parameter und Druckertypen an.

38. Wofür wird ein Scanner verwendet? Welche anderen Geräte mit ähnlichen Zwecken kennen Sie?

39. Welche Geräte müssen in einem Computer enthalten sein, damit er in einer Multimedia-Umgebung arbeiten kann?

40. Wofür werden Modems verwendet?

41. Was ist eine Computerfamilie?

42. Welche Computer gelten als softwarekompatibel?

43. Nennen Sie die Grundmodelle der IBM PC-Familie. Wie unterscheiden sie sich voneinander?

Computers

Systemeinheit;

Tastaturen

Monitor

elektronische Schaltkreise

Netzteil

fährt

Festplatte

Grundlegende Peripheriegeräte von Personalcomputern.

Zusätzliche Geräte

An die Systemeinheit eines IBM PC-Rechners können Sie verschiedene Ein-/Ausgabegeräte anschließen und so dessen Funktionalität erweitern. Viele Geräte werden über spezielle Buchsen (Anschlüsse) angeschlossen, die sich normalerweise an der Rückwand der Computersystemeinheit befinden. Zu diesen Geräten zählen neben Monitor und Tastatur auch:

Drucker- zum Drucken von Text- und Grafikinformationen;

Maus- ein Gerät, das die Eingabe von Informationen in einen Computer erleichtert;

Joystick- ein Manipulator in Form eines aufklappbaren Griffs mit Knopf, der hauptsächlich für Computerspiele verwendet wird;

Sowie andere Geräte.

Der Anschluss dieser Geräte erfolgt über spezielle Drähte (Kabel). Zum Schutz vor Fehlern („narrensicher“) sind die Stecker zum Einstecken dieser Kabel unterschiedlich ausgeführt, sodass das Kabel einfach nicht in die falsche Buchse gesteckt wird.

Einige Geräte können in die Computersystemeinheit eingesetzt werden, zum Beispiel:

Modem- Informationen mit anderen Computern über das Telefonnetz auszutauschen;

Faxmodem- kombiniert Modem- und Telefaxfunktionen;

Streamer- zum Speichern von Daten auf Magnetband.

Einige Geräte, zum Beispiel viele Arten von Scannern (Geräte zur Eingabe von Bildern und Texten in einen Computer), verwenden eine gemischte Verbindungsmethode: In die Systemeinheit des Computers wird nur eine elektronische Platine (Controller) eingesetzt, die den Betrieb des Geräts steuert. und das Gerät selbst ist mit einem Kabel mit dieser Platine verbunden.

Hauptklassen von PC-Software und ihr Zweck. Das Konzept der Installation und Deinstallation von Programmen.

Programme, die auf einem Computer ausgeführt werden, können in drei Kategorien unterteilt werden:

angewandt Programme, direkte Sicherstellung der von Benutzern geforderten Arbeitsleistung: Bearbeiten von Texten, Zeichnen von Bildern, Verarbeiten von Informationsfeldern usw.;

systemisch Programme, Durchführen verschiedener Hilfsfunktionen, z. B. Erstellen von Kopien verwendeter Informationen, Ausgeben von Hilfeinformationen zum Computer, Überprüfen der Funktionalität von Computergeräten usw.;

instrumental Systeme(Programmiersysteme), die die Erstellung neuer Computerprogramme gewährleisten.

Es ist klar, dass die Grenzen zwischen diesen drei Programmklassen sehr willkürlich sind; zum Beispiel kann ein Systemprogramm einen Texteditor enthalten, d. h. angewandtes Programm.

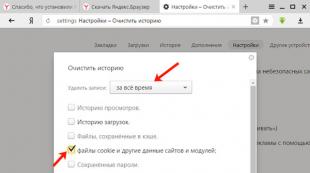

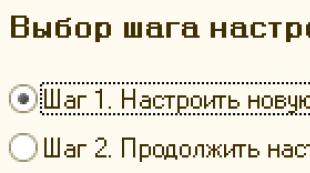

Installation von Programmen– Installation des Programms auf einem PC. In diesem Fall werden Informationen über das Programm häufig in die PC-Registrierung geschrieben.

Programme deinstallieren– Der umgekehrte Vorgang der Installation, d. h. Entfernen des Programms vom PC.

Treiber. Eine wichtige Klasse von Systemprogrammen sind Treiberprogramme. Sie erweitern die Möglichkeiten von DOS, Computer-Eingabe-/Ausgabegeräte (Tastatur, Festplatte, Maus usw.), RAM usw. zu verwalten. Mithilfe von Treibern können Sie neue Geräte an Ihren Computer anschließen oder vorhandene Geräte auf nicht standardmäßige Weise verwenden.

Zweck und Hauptfunktionen des Total Commander-Programms.

Der Total Commander-Dateimanager bietet eine weitere Möglichkeit, mit Dateien und Ordnern in der Windows-Umgebung zu arbeiten. Das Programm ermöglicht Ihnen in einfacher und visueller Form die Durchführung von Vorgängen mit dem Dateisystem wie das Verschieben von einem Verzeichnis in ein anderes, das Erstellen, Umbenennen, Kopieren, Verschieben, Suchen, Anzeigen und Löschen von Dateien und Verzeichnissen und vieles mehr.

Total Commander ist kein Standard-Windows-Programm, d.h. wird nicht zusammen mit der Installation von Windows selbst auf dem Computer installiert. Das Total Commander-Programm wird nach der Installation von Windows separat installiert.

Der Arbeitsbereich des Total Commander-Programmfensters unterscheidet sich von vielen anderen dadurch, dass er in zwei Teile (Panels) unterteilt ist, in denen jeweils der Inhalt verschiedener Festplatten und Verzeichnisse angezeigt werden kann.

Beispielsweise kann ein Benutzer den Inhalt des Laufwerks D: im linken Bereich anzeigen und eines der Verzeichnisse auf dem Laufwerk C: im rechten Bereich eingeben. Dadurch wird es möglich, in beiden Teilen des Fensters gleichzeitig mit Dateien und Ordnern zu arbeiten.

Arbeiten mit Dateien und Ordnern in Total Commander:

· Von Verzeichnis zu Verzeichnis wechseln

· Auswählen von Dateien und Verzeichnissen

· Kopieren von Dateien und Verzeichnissen

· Verschieben von Dateien und Verzeichnissen

· Verzeichniserstellung

· Löschen von Dateien und Verzeichnissen

· Umbenennen von Dateien und Verzeichnissen

· Schnelle Verzeichnissuche

Das Konzept der Archivierung und Entarchivierung von Dateien. Grundlegende Techniken für die Arbeit mit dem ARJ-Archivierungsprogramm.

Programme zum Packen (Archivieren) von Dateien ermöglichen es Ihnen in der Regel, Kopien von Dateien auf der Festplatte in komprimierter Form in eine Archivdatei zu legen (Archivierung), Dateien aus dem Archiv zu extrahieren (Entarchivierung), das Inhaltsverzeichnis des Archivs anzuzeigen, usw. Verschiedene Programme unterscheiden sich im Format der Archivdateien, der Betriebsgeschwindigkeit, dem Grad der Komprimierung der Dateien bei der Archivierung und der Benutzerfreundlichkeit.

Einstellen der ARJ-Programmfunktionen erfolgt durch Angabe des Befehlscodes und der Modi. Der Befehlscode besteht aus einem einzelnen Buchstaben. Er wird in der Befehlszeile unmittelbar nach dem Programmnamen angezeigt und gibt die Art der Aktivität an, die das Programm ausführen muss. Zum Beispiel A – Hinzufügen von Dateien zum Archiv, T – Testen (Überprüfen) des Archivs, E – Extrahieren von Dateien aus dem Archiv usw.

Um genau zu verdeutlichen, welche Aktionen vom ARJ-Programm benötigt werden, können Sie Modi festlegen. Modi können an einer beliebigen Stelle in der Befehlszeile nach dem Befehlscode angegeben werden; sie werden entweder mit vorangestelltem „-“-Zeichen angegeben: -V, -M usw., oder mit vorangestelltem „/“-Zeichen: /V, /M, usw. . (Diese beiden Methoden können jedoch nicht in derselben Befehlszeile gemischt werden).

Modi zur Auswahl archivierter Dateien. Das ARJ-Programm verfügt über drei Hauptmodi zum Speichern von Dateien in einem Archiv:

Hinzufügen – Hinzufügen aller Dateien zum Archiv;

Update – Hinzufügen neuer Dateien zum Archiv;

Auffrischen – Hinzufügen neuer Versionen der im Archiv vorhandenen Dateien.

Extrahieren von Dateien aus dem Archiv. Das ARJ-Programm selbst extrahiert Dateien aus seinen Archiven. Aufrufformat: Befehlsmodus-Archivname (Verzeichnis\) (Dateinamen).

Netzwerkstruktur

Die Knoten und Rückgrate des Internets sind seine Infrastruktur, und im Internet gibt es mehrere Dienste (E-Mail, USENET, TELNET, WWW, FTP usw.), einer der ersten Dienste ist E-Mail. Derzeit kommt der Großteil des Datenverkehrs im Internet vom World Wide Web-Dienst.

Das Funktionsprinzip des WWW-Dienstes wurde 1989 von den Physikern Tim Bernes-Lee und Robert Caillot am europäischen Forschungszentrum CERN (Genf) entwickelt. Derzeit enthält der Internet-Webdienst Millionen von Informationsseiten mit verschiedenen Arten von Dokumenten.

Die Komponenten der Internetstruktur werden zu einer gemeinsamen Hierarchie zusammengefasst. Das Internet vereint viele verschiedene Computernetzwerke und einzelne Computer, die Informationen untereinander austauschen. Alle Informationen im Internet werden auf Webservern gespeichert. Der Informationsaustausch zwischen Webservern erfolgt über Hochgeschwindigkeitsautobahnen.

Zu diesen Autobahnen gehören: dedizierte analoge und digitale Telefonleitungen, optische Kommunikationskanäle und Funkkanäle, einschließlich Satellitenkommunikationsleitungen. Über Hochgeschwindigkeitsautobahnen verbundene Server bilden den Grundbestandteil des Internets.

Benutzer stellen über Router lokaler Internetdienstanbieter oder Dienstanbieter (ISPs) eine Verbindung zum Netzwerk her, die über regionale Anbieter dauerhafte Internetverbindungen haben. Ein regionaler Anbieter verbindet sich mit einem größeren nationalen Anbieter, der Knotenpunkte in verschiedenen Städten des Landes hat.

Netzwerke nationaler Anbieter werden zu Netzwerken transnationaler Anbieter bzw. First-Tier-Anbietern zusammengefasst. Gemeinsame Netzwerke erstklassiger Anbieter bilden das globale Internet-Netzwerk.

Suche nach Informationen im Internet

Die Hauptaufgabe des Internets besteht darin, die notwendigen Informationen bereitzustellen. Das Internet ist ein Informationsraum, in dem man auf fast jede Frage, die den Nutzer interessiert, eine Antwort finden kann. Dabei handelt es sich um ein riesiges globales Netzwerk, in das Ströme kleinerer Netzwerke wie Informationsströme fließen. Jeder Benutzer mit einem PC und den entsprechenden Programmen kann sich mit dem Netzwerk verbinden und seine Fähigkeiten für verschiedene Zwecke nutzen – Freizeit verbringen, studieren, wissenschaftliche Arbeiten lesen, E-Mails senden usw.

Grundlegende Methoden zur Informationssuche im Internet:

1. Direkte Suche über Hypertext-Links.

Da alle Websites im WWW-Bereich tatsächlich miteinander verbunden sind, kann die Suche nach Informationen durch die sequentielle Anzeige verwandter Seiten mit einem Browser erfolgen. Obwohl diese vollständig manuelle Suchmethode in einem Web mit mehr als 60 Millionen Knoten völlig anachronistisch erscheint, ist das „manuelle“ Durchsuchen von Webseiten oft die einzige Option in den letzten Phasen der Informationssuche, wenn das mechanische „Graben“ einer tieferen Analyse Platz macht. Auch für diese Art der Recherche gilt die Verwendung von Katalogen, Rubriken- und Themenverzeichnissen sowie allerlei kleinen Verzeichnissen.

2. Nutzung von Suchmaschinen. Heute ist diese Methode eine der wichtigsten und tatsächlich einzigen Methode bei der Durchführung einer Vorsuche. Das Ergebnis des Letzteren kann eine Liste von Netzwerkressourcen sein, die einer detaillierten Betrachtung unterliegen.

Typischerweise basiert die Verwendung von Suchmaschinen auf der Verwendung von Schlüsselwörtern, die als Suchargumente an Suchserver übergeben werden: wonach gesucht werden soll. Bei korrekter Durchführung erfordert die Erstellung einer Liste von Schlüsselwörtern Vorarbeiten zur Zusammenstellung eines Thesaurus.

3. Suchen Sie mit Spezialwerkzeugen. Diese vollautomatisierte Methode kann für die Durchführung erster Recherchen sehr effektiv sein. Eine der Technologien dieser Methode basiert auf der Verwendung spezieller Programme – Spider, die Webseiten automatisch scannen und nach den erforderlichen Informationen darauf suchen. Tatsächlich handelt es sich hierbei um eine automatisierte Version des oben beschriebenen Surfens mithilfe von Hypertext-Links (Suchmaschinen verwenden ähnliche Methoden zum Aufbau ihrer Indextabellen). Es versteht sich von selbst, dass automatische Suchergebnisse zwangsläufig eine weitere Verarbeitung erfordern.

Der Einsatz dieser Methode empfiehlt sich, wenn der Einsatz von Suchmaschinen nicht die notwendigen Ergebnisse liefern kann (z. B. aufgrund der Nichtstandardisierung der Suchanfrage, die durch bestehende Suchmaschinentools nicht ausreichend spezifiziert werden kann). In manchen Fällen kann diese Methode sehr effektiv sein. Die Wahl zwischen der Verwendung eines Spiders oder Suchservern ist eine Variante der klassischen Wahl zwischen der Verwendung universeller oder spezialisierter Tools.

4. Analyse neuer Ressourcen. Die Suche nach neu erstellten Ressourcen kann erforderlich sein, wenn wiederholte Suchzyklen durchgeführt werden, nach den neuesten Informationen gesucht wird oder um Trends in der Entwicklung des Forschungsobjekts im Laufe der Zeit analysiert werden. Ein weiterer möglicher Grund kann darin liegen, dass die meisten Suchmaschinen ihre Indizes mit erheblicher Verzögerung aktualisieren durch die gigantischen Mengen an verarbeiteten Daten, und diese Verzögerung ist in der Regel umso größer, je weniger populär das Thema ist, für das man sich interessiert. Diese Überlegung kann bei der Suche in einem hochspezialisierten Themengebiet von großer Bedeutung sein.

Grundkonzepte von ET

Das Arbeitsfenster von Microsoft Excel-Tabellen enthält die folgenden Steuerelemente: Titelleiste, Menüleiste, Symbolleisten, Formelleiste, Arbeitsfeld, Statusleiste.

Das Excel-Dokument wird aufgerufen Arbeitsmappe. Eine Arbeitsmappe ist eine Sammlung von Arbeitsblättern. Das Dokumentfenster in Excel zeigt das aktuelle Arbeitsblatt an. Jedes Arbeitsblatt hat einen Titel, der auf dem Arbeitsblattetikett erscheint.

Schnittstellenstruktur

Nach dem Start von Microsoft Excel erscheint das entsprechende Fenster auf dem Bildschirm.

Arbeitsfenster des Programms:

Die Titelleiste, die Folgendes enthält: das Systemmenü, den Titel selbst und Fenstersteuerungsschaltflächen.

Menüleiste.

Symbolleisten: Formatierung und Standard

· Statusleiste.

· Formelleiste, die Folgendes enthält: Namensfeld; Tasten zum Eingeben, Abbrechen und Funktionsassistenten; und eine Funktionslinie.

Kontextmenü

Neben dem Hauptmenü, das in allen Windows-Anwendungen ständig auf dem Bildschirm angezeigt wird, nutzt Excel, wie auch andere MS Office-Programme, aktiv das Kontextmenü. Das Kontextmenü bietet schnellen Zugriff auf häufig verwendete Befehle für ein bestimmtes Objekt in der jeweiligen Situation.

Wenn Sie mit der rechten Maustaste auf ein Symbol, eine Zelle, eine ausgewählte Zellgruppe oder ein eingebettetes Objekt klicken, öffnet sich neben dem Mauszeiger ein Menü mit Grundfunktionen. Die im Kontextmenü enthaltenen Befehle beziehen sich immer auf das aktive (ausgewählte) Objekt.

Symbolleisten

Möglichkeiten zum Ein-/Ausblenden von Symbolleisten:

Erster Weg:

1.Klicken Sie mit der rechten Maustaste auf eine beliebige Symbolleiste ( PKM). Es erscheint ein Kontextmenü für die Liste der Symbolleisten.

2.Aktivieren oder deaktivieren Sie das Kontrollkästchen neben dem Namen der gewünschten Symbolleiste, indem Sie in der Liste auf den Namen der gewünschten Symbolleiste klicken.

Zweiter Weg:

1.Wählen Sie den Befehl in der Menüleiste Sicht. Das Befehlsmenü „Ansicht“ wird angezeigt.

2. Bewegen Sie den Cursor auf eine Zeile Symbolleisten. Das Befehlsmenü der Symbolleiste wird angezeigt.

3.Aktivieren oder deaktivieren Sie das Kontrollkästchen neben dem Namen der gewünschten Symbolleiste.

Formelleiste

Die Formelleiste dient zum Eingeben und Bearbeiten von Werten oder Formeln in Zellen oder Diagrammen sowie zum Anzeigen der Adresse der aktuellen Zelle.

Arbeitsbuch, Blatt

Eine Arbeitsmappe ist ein Dokument mit mehreren Blättern, die Tabellen, Diagramme oder Makros enthalten können. Alle Arbeitsblätter werden in einer Datei gespeichert.

Zellenblock

Als Ein Zellenblock kann als Zeile oder Teil einer Zeile, als Spalte oder Teil einer Spalte sowie als Rechteck bestehend aus mehreren Zeilen und Spalten oder Teilen davon betrachtet werden. Die Adresse eines Zellenblocks wird durch die Angabe von Verweisen auf seine erste und letzte Zelle angegeben, zwischen denen ein Trennzeichen steht – ein Doppelpunkt (z. B. B1: D6).

Datentypen in MS Excel

Es gibt zwei Arten von Daten, die in Excel-Arbeitsblattzellen eingegeben werden können: Konstanten und Formeln.

Konstanten sind wiederum unterteilt in: numerische Werte, Textwerte, Datums- und Uhrzeitwerte, boolesche Werte und Fehlerwerte.

Numerische Werte

Numerische Werte können Zahlen von 0 bis 9 sowie Sonderzeichen enthalten: + - E e () . , $% /

Um einen numerischen Wert in eine Zelle einzugeben, müssen Sie die gewünschte Zelle auswählen und die erforderliche Zahlenkombination über die Tastatur eingeben. Die von Ihnen eingegebenen Zahlen werden sowohl in der Zelle als auch in der Bearbeitungsleiste angezeigt. Wenn Sie mit der Eingabe fertig sind, müssen Sie die Eingabetaste drücken. Danach wird die Nummer in die Zelle geschrieben. Standardmäßig wird nach dem Drücken der Eingabetaste die Zelle, die sich eine Zeile darunter befindet, aktiv, aber mit dem Befehl „Extras“ – „Optionen“ auf der Registerkarte „Bearbeiten“ können Sie die gewünschte Übergangsrichtung zur nächsten Zelle nach der Eingabe festlegen. oder den Übergang ganz eliminieren. Wenn Sie nach der Eingabe einer Zahl eine der Zellennavigationstasten (Tab, Umschalt+Tab ...) drücken, wird die Zahl in der Zelle fixiert und der Eingabefokus wird auf die angrenzende Zelle verschoben.

Manchmal müssen Sie lange Zahlen eingeben. Für die Darstellung in der Bearbeitungsleiste wird jedoch die Exponentialschreibweise mit maximal 15 signifikanten Ziffern verwendet. Die Genauigkeit des Werts wird so gewählt, dass die Zahl in der Zelle angezeigt werden kann.

In diesem Fall wird der Wert in der Zelle als Eingabe- oder Anzeigewert bezeichnet.

Der Wert in der Bearbeitungsleiste wird als gespeicherter Wert bezeichnet.

Die Anzahl der eingegebenen Ziffern hängt von der Spaltenbreite ab. Reicht die Breite nicht aus, rundet Excel den Wert entweder auf oder zeigt ###-Zeichen an. In diesem Fall können Sie versuchen, die Zellengröße zu erhöhen.

Textwerte

Die Eingabe von Text erfolgt völlig ähnlich wie die Eingabe numerischer Werte. Sie können nahezu beliebige Zeichen eingeben. Wenn die Länge des Textes die Breite der Zelle überschreitet, überlappt der Text die angrenzende Zelle, obwohl er sich tatsächlich in derselben Zelle befindet. Wenn in einer angrenzenden Zelle auch Text vorhanden ist, überlappt dieser den Text in der angrenzenden Zelle.

Um die Zellenbreite an den längsten Text anzupassen, klicken Sie auf den Spaltenrand in der Kopfzeile. Wenn Sie also auf die Zeile zwischen den Überschriften der Spalten A und B klicken, wird die Zellenbreite automatisch an den längsten Wert in dieser Spalte angepasst.

Wenn Sie eine Zahl als Textwert eingeben müssen, müssen Sie der Zahl ein Apostroph voranstellen oder die Zahl in Anführungszeichen setzen – „123 „123“.

Anhand der Ausrichtung können Sie erkennen, welcher Wert (numerisch oder Text) in eine Zelle eingegeben wird. Standardmäßig wird Text linksbündig ausgerichtet, während Zahlen rechtsbündig ausgerichtet sind.

Bei der Eingabe von Werten in einen Zellbereich erfolgt die Eingabe von links nach rechts und von oben nach unten. Diese. Wenn Sie Werte eingeben und die Eingabe durch Drücken der Eingabetaste abschließen, bewegt sich der Cursor in die angrenzende Zelle rechts, und wenn er das Ende des Zellenblocks in der Zeile erreicht, bewegt er sich in die Zeile darunter Zelle ganz links.

Werte in einer Zelle ändern

Um Werte in einer Zelle zu ändern, bevor die Eingabe übernommen wird, müssen Sie wie in jedem Texteditor die Entf- und die Rücktaste verwenden. Wenn Sie eine bereits fixierte Zelle ändern müssen, müssen Sie auf die gewünschte Zelle doppelklicken. Daraufhin erscheint ein Cursor in der Zelle. Anschließend können Sie die Daten in der Zelle bearbeiten. Sie können einfach die gewünschte Zelle auswählen, dann den Cursor in der Bearbeitungsleiste positionieren, wo der Inhalt der Zelle angezeigt wird, und dann die Daten bearbeiten. Nachdem Sie die Bearbeitung abgeschlossen haben, müssen Sie die Eingabetaste drücken, um die Änderungen zu übernehmen. Im Falle einer fehlerhaften Bearbeitung kann die Situation mit der Schaltfläche „Rückgängig“ (Strg+Z) „zurückgespult“ werden.

26. Erstellen von Diagrammen in MS Excel.

Um ein Diagramm zu erstellen, müssen Sie zunächst die Daten für das Diagramm in eine Excel-Tabelle eingeben. Wählen Sie Ihre Daten aus und verwenden Sie dann den Diagrammassistenten, der Sie Schritt für Schritt durch den Prozess der Auswahl eines Diagrammtyps und verschiedener Diagrammoptionen für Ihr Diagramm führt. Im Diagrammassistenten – Schritt 1 von 4 Geben Sie im Dialogfeld „Diagrammtyp“ den Diagrammtyp an, den Sie für das Diagramm verwenden möchten. Im Diagrammassistenten – Schritt 2 von 4- Dialogfeld „Datenquelle des Diagramms“. Sie können den Datenbereich und die Art und Weise angeben, wie die Reihen im Diagramm angezeigt werden. IN Diagrammassistent – Schritt 3 von 4 Im Dialogfeld „Diagrammoptionen“ können Sie das Erscheinungsbild des Diagramms weiter ändern, indem Sie auf den sechs Registerkarten „Diagrammoptionen“ auswählen. Um diese Einstellungen zu ändern, sehen Sie sich das Beispieldiagramm an, um sicherzustellen, dass das Diagramm wie erwartet aussieht . Im Diagrammassistenten – Schritt 4 von 4 Wählen Sie im Dialogfeld „Diagrammplatzierung“ einen Ordner aus, in dem das Diagramm platziert werden soll, indem Sie einen der folgenden Schritte ausführen:

Klicken Sie auf die Schaltfläche „Auf neuem Blatt“, um das Diagramm auf einem neuen Blatt anzuzeigen.

Klicken Sie auf die Schaltfläche „Als Objekt in“, um das Diagramm als Objekt im Blatt anzuzeigen.

Klicken Sie auf Fertig stellen.

Zum Seitenanfang gehen

MS PowerPoint. Funktionen des Präsentationsprogramms. Grundlegendes Konzept.

PowerPoint XP ist eine Anwendung zur Vorbereitung von Präsentationen, deren Folien der Öffentlichkeit in Form von gedruckten Grafikmaterialien oder durch Vorführung eines elektronischen Diafilms präsentiert werden. Indem Sie den Inhalt Ihres Berichts erstellen oder importieren, können Sie ihn schnell mit Zeichnungen, Diagrammen und Animationseffekten dekorieren. Navigationselemente ermöglichen die Erstellung interaktiver Präsentationen, die vom Betrachter gesteuert werden.

PowerPoint-Dateien werden aufgerufen Präsentationen und ihre Elemente sind Folien.

DESIGNVORLAGEN

Mit Microsoft PowerPoint können Sie Designvorlagen erstellen,

die in einer Präsentation verwendet werden können, um ihr ein vollendetes, professionelles Aussehen zu verleihen.

Designvorlage - Hierbei handelt es sich um eine Vorlage, deren Format zur Vorbereitung anderer Präsentationen verwendet werden kann.

Zweck und Eigenschaften der Hauptgeräte eines Personalcomputers wie eines IBM-PCs.

Computers- Dies sind die Werkzeuge zur Verarbeitung von Informationen. IBM PC-Grundblöcke

Normalerweise bestehen IBM PC-Personalcomputer aus drei Teilen (Blöcken):

Systemeinheit;

Tastaturen, mit dem Sie Zeichen in den Computer eingeben können;

Monitor(oder Anzeige) – zum Anzeigen von Text- und Grafikinformationen.

Obwohl die Systemeinheit von diesen Teilen des Computers am wenigsten beeindruckend aussieht, ist sie der „Hauptteil“ des Computers. Es enthält alle Hauptkomponenten des Computers:

elektronische Schaltkreise Geräte, die den Betrieb des Computers steuern (Mikroprozessor, RAM, Gerätecontroller usw., siehe unten);

Netzteil, das die Netzstromversorgung in Niederspannungs-Gleichstrom umwandelt, der den elektronischen Schaltkreisen des Computers zugeführt wird;

fährt(oder Diskettenlaufwerke), die zum Lesen und Beschreiben von Disketten (Disketten) verwendet werden;

Festplatte Magnetplatte, die zum Lesen und Schreiben auf eine nicht entfernbare Festplatte (Festplatte) bestimmt ist.

IBM ist heute ein bekanntes Unternehmen. Sie hat große Spuren in der Computergeschichte hinterlassen, und bis heute hat ihr Tempo in dieser schwierigen Angelegenheit nicht nachgelassen. Das Interessanteste ist, dass nicht jeder weiß, warum IBM so berühmt ist. Ja, jeder hat vom IBM-PC gehört, dass er Laptops herstellte und dass er einst ernsthaft mit Apple konkurrierte. Zu den Verdiensten des blauen Riesen zählen jedoch eine Vielzahl wissenschaftlicher Entdeckungen sowie die Einführung verschiedener Erfindungen in den Alltag. Manchmal fragen sich viele Menschen, woher diese oder jene Technologie kommt. Und alles kommt von dort – von IBM. Fünf Nobelpreisträger für Physik erhielten ihre Preise für Erfindungen, die innerhalb der Mauern dieses Unternehmens gemacht wurden.

Dieses Material soll Aufschluss über die Entstehungs- und Entwicklungsgeschichte von IBM geben. Gleichzeitig werden wir über seine wichtigsten Erfindungen sowie zukünftige Entwicklungen sprechen.

Zeit der Entstehung

Die Ursprünge von IBM reichen bis ins Jahr 1896 zurück, als der herausragende Ingenieur und Statistiker Herman Hollerith Jahrzehnte vor dem Aufkommen der ersten elektronischen Computer ein Unternehmen zur Herstellung von Tabelliermaschinen gründete, das den Namen TMC (Tabulated Machine Company) erhielt. Der Erfolg seiner ersten selbst hergestellten Rechen- und Analysemaschinen veranlasste Herrn Hollerith, einen Nachkommen deutscher Auswanderer, der offen stolz auf seine Wurzeln war, dazu. Der Kern der Erfindung des Großvaters des Blauen Riesen bestand darin, dass er einen elektrischen Schalter entwickelte, der es ermöglichte, Daten in Zahlen zu kodieren. In diesem Fall handelte es sich bei den Informationsträgern um Karten, in die in einer bestimmten Reihenfolge Löcher gestanzt wurden, wonach die gelochten Karten maschinell sortiert werden konnten. Diese 1889 von Herman Hollerith patentierte Entwicklung löste eine echte Sensation aus, die es dem 39-jährigen Erfinder ermöglichte, einen Auftrag zur Lieferung seiner einzigartigen Maschinen an das US-Statistikministerium zu erhalten, das sich auf die Volkszählung von 1890 vorbereitete.

Der Erfolg war überwältigend: Die Verarbeitung der gesammelten Daten dauerte nur ein Jahr, im Gegensatz zu den acht Jahren, die die Statistiker des US Census Bureau brauchten, um die Ergebnisse der Volkszählung von 1880 zu erhalten. Damals zeigte sich in der Praxis der Vorteil von Rechenmechanismen bei der Lösung solcher Probleme, der den zukünftigen „digitalen Boom“ weitgehend vorwegnahm. Die erwirtschafteten Mittel und die geknüpften Kontakte halfen Herrn Hollerith bei der Gründung des TMC-Unternehmens im Jahr 1896. Zunächst versuchte das Unternehmen, kommerzielle Maschinen herzustellen, doch am Vorabend der Volkszählung von 1900 widmete es sich der Produktion von Zähl- und Analysemaschinen für das US Census Bureau. Doch drei Jahre später, als der staatliche „Futtertrog“ geschlossen wurde, wandte Herman Hollerith seine Aufmerksamkeit wieder der kommerziellen Nutzung seiner Entwicklungen zu.

Obwohl das Unternehmen eine Phase schnellen Wachstums erlebte, verschlechterte sich der Gesundheitszustand seines Gründers und Inspirators stetig. Dies zwang ihn 1911, das Angebot des Millionärs Charles Flint anzunehmen, TMC zu kaufen. Der Deal hatte einen Wert von 2,3 Millionen US-Dollar, wovon Hollerith 1,2 Millionen US-Dollar erhielt. Tatsächlich handelte es sich nicht um einen einfachen Aktienkauf, sondern um die Fusion von TMC mit den Unternehmen ITRC (International Time Recording Company) und CSC (Computing Scale Corporation), wodurch die CTR (Computing Tabulated Recording) Corporation entstand wurde geboren. Es wurde zum Prototyp des modernen IBM. Und wenn viele Leute Herman Hollerith als den Großvater des „blauen Riesen“ bezeichnen, dann gilt Charles Flint als sein Vater.

Herr Flint war unbestreitbar ein Finanzgenie mit einem Gespür dafür, sich starke Unternehmensallianzen vorzustellen, von denen viele ihren Gründer überlebt haben und weiterhin eine entscheidende Rolle in ihren Bereichen spielen. Er war aktiv an der Gründung des panamerikanischen Kautschukherstellers U.S. Rubber beteiligt, einem der einst weltweit führenden Kaugummihersteller American Chicle (seit 2002, heute Adams, Teil von Cadbury Schweppes). Für seinen Erfolg bei der Konsolidierung der Unternehmensmacht der Vereinigten Staaten wurde er als „Vater der Trusts“ bezeichnet. Aus dem gleichen Grund ist jedoch die Bewertung seiner Rolle unter dem Gesichtspunkt der positiven oder negativen Auswirkungen, niemals jedoch unter dem Gesichtspunkt der Bedeutung, sehr zweideutig. Wie paradox es ist, dass Charles Flints organisatorische Fähigkeiten in Regierungsabteilungen hoch geschätzt wurden und er sich immer an Orten wiederfand, an denen normale Beamte nicht offen agieren konnten oder ihre Arbeit weniger effektiv war. Insbesondere wird ihm die Teilnahme an einem geheimen Projekt zum Kauf von Schiffen auf der ganzen Welt und zum Umbau dieser in Kriegsschiffe während des Spanisch-Amerikanischen Krieges von 1898 zugeschrieben.

Die 1911 von Charles Flint gegründete CTR Corporation produzierte eine breite Palette einzigartiger Geräte, darunter Zeiterfassungssysteme, Waagen, automatische Fleischschneider und, was sich für die Entwicklung des Computers als besonders wichtig erwies, Lochkartengeräte. 1914 übernahm Thomas J. Watson Sr. die Geschäftsführung und 1915 wurde er Präsident von CTR.

Das nächste große Ereignis in der Geschichte von CTR war die Namensänderung in International Business Machines Co., Limited, kurz IBM. Dies geschah in zwei Etappen. Unter dieser Marke betrat das Unternehmen zunächst 1917 den kanadischen Markt. Offenbar wollte sie damit unterstreichen, dass sie mittlerweile ein echter internationaler Konzern ist. Im Jahr 1924 wurde die amerikanische Division auch als IBM bekannt.

Während der Weltwirtschaftskrise und des Zweiten Weltkriegs

Die nächsten 25 Jahre in der Geschichte von IBM verliefen mehr oder weniger stabil. Auch während der Weltwirtschaftskrise in den USA setzte das Unternehmen seine Aktivitäten im gleichen Tempo fort, praktisch ohne Mitarbeiter zu entlassen, was man von anderen Unternehmen nicht behaupten konnte.

In diesem Zeitraum sind für IBM mehrere wichtige Ereignisse zu verzeichnen. 1928 führte das Unternehmen einen neuen Lochkartentyp mit 80 Spalten ein. Sie hieß IBM-Karte und wurde in den letzten Jahrzehnten von den Rechenmaschinen und dann von den Computern des Unternehmens verwendet. Ein weiteres bedeutendes Ereignis für IBM zu dieser Zeit war eine große staatliche Anordnung zur Systematisierung der Jobdaten von 26 Millionen Menschen. Das Unternehmen selbst bezeichnet es als „die größte Abwicklungstransaktion aller Zeiten“. Darüber hinaus öffnete dies dem blauen Riesen die Tür zu anderen Regierungsaufträgen, genau wie zu Beginn von TMC.

Buch „IBM und der Holocaust“

Es gibt mehrere Hinweise auf die Zusammenarbeit von IBM mit dem faschistischen Regime in Deutschland. Die Datenquelle hier ist Edwin Blacks Buch „IBM and the Holocaust“. Der Name verrät deutlich, zu welchem Zweck die Rechenmaschinen des blauen Riesen eingesetzt wurden. Sie führten Statistiken über jüdische Gefangene. Es werden sogar die Codes angegeben, die zur Organisation der Daten verwendet wurden: Code 8 – Juden, Code 11 – Zigeuner, Code 001 – Auschwitz, Code 001 – Buchenwald und so weiter.

Nach Angaben der IBM-Geschäftsführung verkaufte das Unternehmen jedoch nur Geräte an das Dritte Reich, und die Frage, wie diese weiterverwendet wurden, geht sie nicht an. Das haben übrigens viele amerikanische Unternehmen getan. IBM eröffnete 1933, also als Hitler an die Macht kam, sogar ein Werk in Berlin. Der Einsatz von IBM-Geräten durch die Nazis hat jedoch eine Kehrseite. Nach der Niederlage Deutschlands war es dank der Maschinen des blauen Riesen möglich, das Schicksal vieler Menschen zu verfolgen. Dies hielt jedoch verschiedene vom Krieg und insbesondere dem Holocaust betroffene Personengruppen nicht davon ab, eine offizielle Entschuldigung von IBM zu fordern. Das Unternehmen weigerte sich, sie mitzubringen. Auch wenn die in Deutschland verbliebenen Mitarbeiter während des Krieges ihre Arbeit fortsetzten und sogar über Genf mit der Unternehmensleitung kommunizierten. IBM selbst lehnte jedoch jegliche Verantwortung für die Aktivitäten seiner Unternehmen in Deutschland während der Kriegszeit von 1941 bis 1945 ab.

In den USA arbeitete IBM während der Kriegszeit für die Regierung und nicht immer in ihrem direkten Geschäftszweig. Seine Produktionsanlagen und Arbeiter waren damit beschäftigt, Gewehre (insbesondere das Browning-Automatikgewehr und den M1-Karabiner), Bombenvisiere, Motorteile usw. herzustellen. Thomas Watson, damals noch Chef des Unternehmens, setzte für dieses Produkt einen nominalen Gewinn von 1 % fest. Und selbst dieser magere Betrag floss nicht in das Sparschwein des blauen Riesen, sondern in die Gründung eines Fonds zur Unterstützung von Witwen und Waisen, die ihre Angehörigen im Krieg verloren hatten.

Auch für Rechenmaschinen in den USA wurden Anwendungen gefunden. Sie wurden für verschiedene mathematische Berechnungen, Logistik und andere Kriegszwecke verwendet. Nicht weniger aktiv wurden sie bei der Arbeit am Manhattan-Projekt eingesetzt, in dessen Rahmen die Atombombe entstand.

Zeit für große Mainframes

Der Beginn der zweiten Hälfte des letzten Jahrhunderts war für die moderne Welt von großer Bedeutung. Dann tauchten die ersten digitalen Computer auf. Und IBM beteiligte sich aktiv an ihrer Entstehung. Der allererste amerikanische programmierbare Computer war der Mark I (vollständiger Name: Aiken-IBM Automatic Sequence Controlled Calculator Mark I). Das Erstaunlichste ist, dass es auf den Ideen von Charles Babbage, dem Erfinder des ersten Computers, basierte. Übrigens hat er es nie fertiggestellt. Im 19. Jahrhundert war dies jedoch schwierig. IBM nutzte seine Berechnungen, übertrug sie auf die Technologien der Zeit und es kam der Mark I auf den Markt. Er wurde 1943 gebaut und ein Jahr später offiziell in Betrieb genommen. Die Geschichte von „Marks“ währte nicht lange. Insgesamt wurden vier Modifikationen produziert, von denen die letzte, Mark IV, 1952 eingeführt wurde.

In den 50er Jahren erhielt IBM von der Regierung einen weiteren Großauftrag zur Entwicklung von Computern für das SAGE-System (Semi Automatic Ground Environment). Hierbei handelt es sich um ein militärisches System zur Verfolgung und zum Abfangen potenzieller feindlicher Bomber. Dieses Projekt ermöglichte dem blauen Riesen Zugang zur Forschung am Massachusetts Institute of Technology. Dann arbeitete er am ersten Computer, der problemlos als Prototyp für moderne Systeme dienen konnte. Es enthielt also einen eingebauten Bildschirm, ein magnetisches Speicherarray, unterstützte Digital-Analog- und Analog-Digital-Umwandlungen, verfügte über eine Art Computernetzwerk, konnte digitale Daten über eine Telefonleitung übertragen und unterstützte Multiprocessing. Darüber hinaus war es möglich, sogenannte „Light Guns“ daran anzuschließen, die bisher häufig als Alternative zum Joystick auf Konsolen und Spielautomaten eingesetzt wurden. Es gab sogar Unterstützung für die erste algebraische Computersprache.

IBM baute 56 Computer für das SAGE-Projekt. Jeder kostete zu Preisen der 1950er Jahre 30 Millionen US-Dollar. An ihnen arbeiteten 7.000 Firmenmitarbeiter, was damals 20 % der Gesamtbelegschaft des Unternehmens ausmachte. Neben großen Gewinnen konnte der blaue Riese unschätzbare Erfahrungen sammeln und Zugang zu militärischen Entwicklungen erhalten. All dies wurde später bei der Entwicklung von Computern der nächsten Generationen verwendet.

Das nächste große Ereignis für IBM war die Veröffentlichung des System/360-Computers. Es ist fast mit dem Wandel einer ganzen Epoche verbunden. Vor ihm produzierte der blaue Riese Systeme auf Basis von Vakuumröhren. Beispielsweise wurde 1948 im Anschluss an den oben erwähnten Mark I der Selective Sequence Electronic Calculator (SSEC) eingeführt, der aus 21.400 Relais und 12.500 Vakuumröhren bestand und mehrere tausend Operationen pro Sekunde ausführen konnte.

Neben SAGE-Computern arbeitete IBM an anderen Projekten für das Militär. Daher erforderte der Koreakrieg den Einsatz schnellerer Rechenmittel als eines großen programmierbaren Taschenrechners. So wurde ein vollelektronischer Computer (nicht aus Relais, sondern aus Lampen) IBM 701 entwickelt, der 25-mal schneller als SSEC arbeitete und gleichzeitig viermal weniger Platz beanspruchte. In den nächsten Jahren wurde die Modernisierung der Röhrencomputer fortgesetzt. Berühmt wurde beispielsweise die Maschine IBM 650, von der etwa 2000 Exemplare produziert wurden.

Nicht weniger bedeutsam für die heutige Computertechnik war die Erfindung eines Geräts namens RAMAC 305 im Jahr 1956. Es wurde zum Prototyp dessen, was heute als HDD oder einfach als Festplatte bezeichnet wird. Die erste Festplatte wog etwa 900 Kilogramm und hatte eine Kapazität von nur 5 MB. Die Hauptinnovation war die Verwendung von 50 runden, ständig rotierenden Aluminiumplatten, auf denen die Informationsträger magnetisierte Elemente waren. Dies ermöglichte einen wahlfreien Zugriff auf Dateien, was gleichzeitig die Geschwindigkeit der Datenverarbeitung deutlich erhöhte. Aber dieses Vergnügen war nicht billig – es kostete zu damaligen Preisen 50.000 Dollar. Im Laufe von 50 Jahren konnten durch den Fortschritt die Kosten für ein Megabyte Daten auf einer Festplatte von 10.000 US-Dollar auf 0,00013 US-Dollar gesenkt werden, basierend auf den durchschnittlichen Kosten einer 1-TB-Festplatte.

Die Mitte des letzten Jahrhunderts war auch durch die Einführung von Transistoren als Ersatz für Lampen gekennzeichnet. Der blaue Riese begann seine ersten Versuche, diese Elemente im Jahr 1958 mit der Ankündigung des IBM 7070-Systems zu nutzen. Etwas später erschienen die Computermodelle 1401 und 1620. Der erste war für die Ausführung verschiedener Geschäftsaufgaben gedacht, der zweite war ein kleiner wissenschaftlicher Computer zur Entwicklung des Entwurfs von Autobahnen und Brücken verwendet. Das heißt, es wurden sowohl kompaktere Spezialcomputer als auch sperrigere, aber viel schnellere Systeme geschaffen. Ein Beispiel für Ersteres ist das Modell 1440, das 1962 für kleine und mittlere Unternehmen entwickelt wurde, und ein Beispiel für Letzteres ist der 7094 – eigentlich ein Supercomputer der frühen 60er Jahre, der in der Luft- und Raumfahrtindustrie eingesetzt wurde.

Ein weiterer Baustein zur Schaffung von System/360 war die Schaffung von Terminalsystemen. Den Benutzern wurden ein separater Monitor und eine separate Tastatur zugewiesen, die mit einem zentralen Computer verbunden waren. Hier ist der Prototyp einer Client/Server-Architektur gepaart mit einem Mehrbenutzer-Betriebssystem.

Wie so oft muss man, um das Beste aus Innovationen herauszuholen, alle bisherigen Entwicklungen aufgreifen, ihre Gemeinsamkeiten finden und dann ein neues System entwerfen, das die besten Aspekte neuer Technologien nutzt. Das 1964 eingeführte IBM System/360 war ein solcher Computer.

Es erinnert ein wenig an moderne Computer, die bei Bedarf aktualisiert werden können und an die sich verschiedene externe Geräte anschließen lassen. Für System/360 wurde eine neue Reihe von 40 Peripheriegeräten entwickelt. Dazu gehörten Festplatten vom Typ IBM 2311 und IBM 2314, Bandlaufwerke vom Typ IBM 2401 und 2405, Lochkartengeräte, OCR-Geräte und verschiedene Kommunikationsschnittstellen.

Eine weitere wichtige Neuerung ist der unbegrenzte virtuelle Raum. Vor System/360 kosteten solche Dinge einen hübschen Cent. Natürlich erforderte diese Innovation einige Umprogrammierungen, aber das Ergebnis war es wert.

Oben haben wir über Spezialcomputer für Wissenschaft und Wirtschaft geschrieben. Stimmen Sie zu, das ist sowohl für den Benutzer als auch für den Entwickler etwas umständlich. System/360 wurde zu einem universellen System, das für die meisten Aufgaben eingesetzt werden konnte. Darüber hinaus konnte es jetzt von einer viel größeren Anzahl von Personen genutzt werden – der gleichzeitige Anschluss von bis zu 248 Endgeräten wurde unterstützt.

Die Entwicklung des IBM System/360 war kein so billiges Unterfangen. Der Computer wurde nur für drei Viertel konzipiert, wofür etwa eine Milliarde Dollar ausgegeben wurden. Weitere 4,5 Milliarden US-Dollar wurden für Investitionen in Fabriken und neue Ausrüstung ausgegeben. Insgesamt wurden fünf Fabriken eröffnet und 60.000 Mitarbeiter eingestellt. Thomas Watson Jr., der 1956 die Nachfolge seines Vaters als Präsident antrat, nannte das Projekt „das teuerste private kommerzielle Projekt in der Geschichte“.

Die 70er und die IBM System/370-Ära

Das nächste Jahrzehnt in der Geschichte von IBM war nicht so revolutionär, aber es fanden mehrere wichtige Ereignisse statt. Die 70er Jahre begannen mit der Veröffentlichung von System/370. Nach mehreren Modifikationen an System/360 wurde dieses System zu einer komplexeren und umfassenderen Neugestaltung des ursprünglichen Mainframes.

Die wichtigste Neuerung von System/370 ist die Unterstützung des virtuellen Speichers, d. h. es handelt sich tatsächlich um eine Erweiterung des Arbeitsspeichers auf Kosten des permanenten Speichers. Heute wird dieses Prinzip in modernen Betriebssystemen der Windows- und Unix-Familien aktiv genutzt. In den ersten Versionen von System/370 war diese Unterstützung jedoch nicht enthalten. Mit der Einführung der System/370 Advanced Function machte IBM 1972 virtuellen Speicher allgemein verfügbar.

Natürlich ist die Liste der Innovationen hier noch nicht zu Ende. Die Mainframes der System/370-Serie unterstützten eine 31-Bit-Adressierung anstelle einer 24-Bit-Adressierung. Standardmäßig wurde die Dual-Prozessor-Unterstützung unterstützt und es bestand auch Kompatibilität mit der 128-Bit-Bruchzahlarithmetik. Ein weiteres wichtiges „Feature“ von System/370 ist die vollständige Abwärtskompatibilität mit System/360. Software natürlich.

Der nächste Großrechner des Unternehmens war das 1990 eingeführte System/390 (oder S/390). Es war ein 32-Bit-System, obwohl es mit der 24-Bit-System/360- und 31-Bit-System/370-Adressierung kompatibel blieb. 1994 wurde es möglich, mehrere System/390-Großrechner zu einem Cluster zusammenzufassen. Diese Technologie wird Parallel Sysplex genannt.

Nach System/390 führte IBM z/Architecture ein. Die wichtigste Neuerung ist die Unterstützung eines 64-Bit-Adressraums. Gleichzeitig wurden neue Großrechner mit einer größeren Anzahl an Prozessoren (zuerst 32, dann 54) auf den Markt gebracht. Das Erscheinen von z/Architecture erfolgte im Jahr 2000, das heißt, diese Entwicklung ist völlig neu. Heute sind in seinem Rahmen System z9 und System z10 verfügbar, die sich weiterhin stetiger Beliebtheit erfreuen. Und darüber hinaus sind sie weiterhin abwärtskompatibel mit System/360 und späteren Mainframes, was ein Rekord für sich ist.

Damit schließen wir das Thema der großen Mainframes ab, weshalb wir über deren Geschichte bis heute gesprochen haben.

Unterdessen schwelt zwischen IBM ein Konflikt mit den Behörden. Vorausgegangen war der Ausstieg der Hauptkonkurrenten des blauen Riesen aus dem Markt für große Computersysteme. Insbesondere NCR und Honeywall beschlossen, sich auf profitablere Nischenmarktsegmente zu konzentrieren. Und System/360 erwies sich als so erfolgreich, dass niemand mit ihm konkurrieren konnte. Dadurch wurde IBM tatsächlich zum Monopolisten auf dem Mainframe-Markt.

All dies führte am 19. Januar 1969 zu einem Prozess. Erwartungsgemäß wurde IBM vorgeworfen, gegen Abschnitt 2 des Sherman Act verstoßen zu haben, der die Haftung für die Monopolisierung oder den Versuch einer Monopolisierung auf dem Markt für elektronische Computersysteme vorsieht, insbesondere für Systeme, die für den geschäftlichen Gebrauch bestimmt sind. Der Prozess dauerte bis 1983 und endete damit, dass IBM seine Geschäftsauffassung ernsthaft überdenkte.

Es ist möglich, dass das Kartellverfahren das Projekt Future Systems beeinflusst hat, in dessen Rahmen das gesamte Wissen und die Erfahrung vergangener Projekte (genau wie zu System / 360-Zeiten) noch einmal gebündelt und ein neuer Computertyp geschaffen werden sollte noch einmal alles bisher Gemachte übertreffen. Die Arbeiten daran fanden zwischen 1971 und 1975 statt. Als Grund für die Schließung wird wirtschaftliche Unzweckmäßigkeit angeführt – Analysten zufolge hätte es sich nicht wie bei System/360 dagegen wehren können. Oder vielleicht hat sich IBM aufgrund des laufenden Rechtsstreits tatsächlich dazu entschieden, etwas zurückzuhalten.

Ein weiteres sehr wichtiges Ereignis in der Computerwelt wird demselben Jahrzehnt zugeschrieben, obwohl es im Jahr 1969 stattfand. IBM begann, Dienstleistungen für die Produktion von Software und die Software selbst getrennt von der Hardwarekomponente zu verkaufen. Heutzutage überrascht dies nur wenige Menschen – selbst die moderne Generation inländischer Benutzer von Raubkopien ist daran gewöhnt, dass sie für Programme bezahlen müssen. Doch dann prasselten zahlreiche Beschwerden, Pressekritik und gleichzeitig Klagen auf den blauen Riesen ein. Infolgedessen begann IBM, nur Anwendungsanwendungen separat zu verkaufen, während die Software zur Steuerung des Computerbetriebs (System Control Programming), eigentlich das Betriebssystem, kostenlos war.

Und ganz zu Beginn der 80er Jahre bewies ein gewisser Bill Gates von Microsoft, dass ein Betriebssystem bezahlt werden kann.

Zeit für kleine Personalcomputer

Bis in die 80er Jahre war IBM bei Großaufträgen sehr aktiv. Mehrmals wurden sie von der Regierung, mehrmals vom Militär angefertigt. In der Regel belieferte das Unternehmen mit seinen Großrechnern Bildungs- und Wissenschaftseinrichtungen sowie Großkonzerne. Es ist unwahrscheinlich, dass jemand einen separaten System/360- oder 370-Schrank für sein Zuhause und ein Dutzend Speicherschränke auf Basis von Magnetbändern und Festplatten gekauft hat, die im Vergleich zum RAMAC 305 bereits um ein Vielfaches kleiner sind.